如何理解OpenAI提出的新摩尔定律?中国隐形计算巨头有话说

发布时间:2023-03-02 09:21:21作者:顺晟科技点击:

ChatGPT遍布全球,与之相关的一切都在最前沿。

OpenAI首席执行官山姆奥特曼(Sam Altman)看似不经意分享的一句话成为热议的焦点:

有人猜测可能是参考了神经网络的参数,但以过去几年的数据来看并不正确。

有人理解为是包括人和AI在内的所有智能体的能力,但如何衡量这个指标却成了问题。

也有很多学者和网友不认同这个判断。IBM科学家格雷迪布奇(Grady Booch)表示,这是无稽之谈,被评为第一热评。

对于这些讨论,奥特曼只是简单的回复“还没开始”。

但无论如何,在AI飞速发展的背后,计算能力是一个清晰可衡量的指标,是不可或缺的条件。

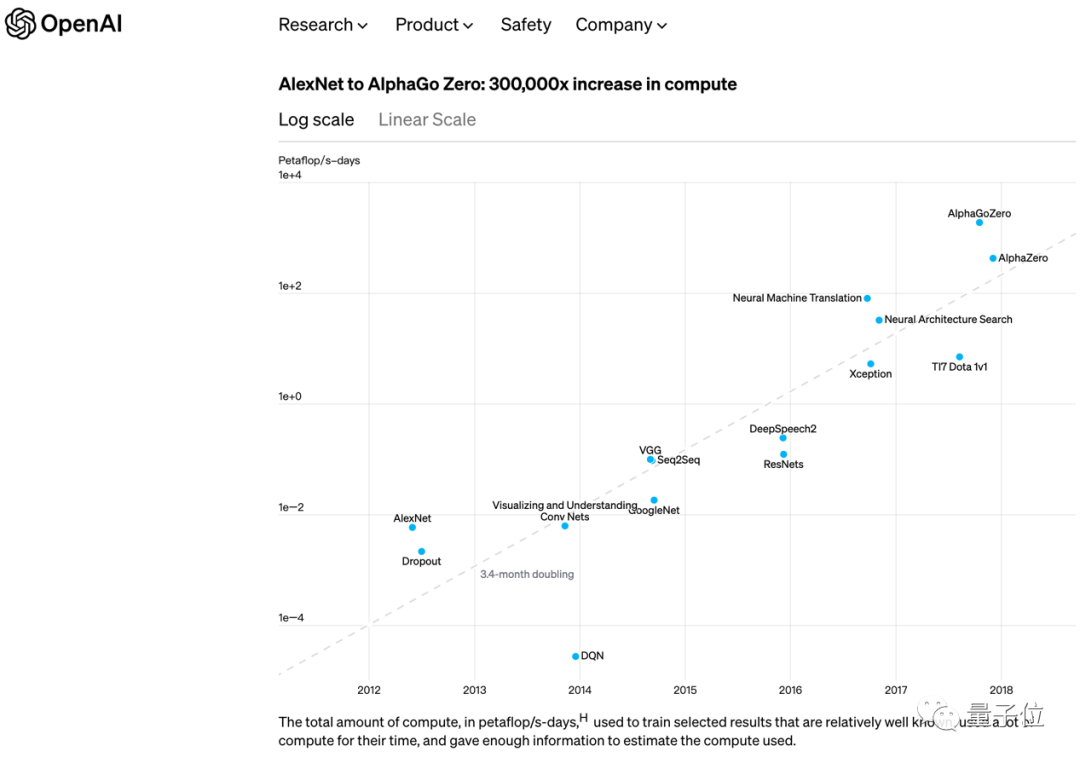

早在2018年,OpenAI也发表了另一个类似摩尔定律的观点:

不久之后,他们自己的GPT-3将这个时间缩短到两个月,并增加了一倍。

在ChatGPT时代,需要考虑的不仅仅是AI训练计算能力,AI推理计算能力是全球月活1亿用户和接入微软必应搜索等产品的重要支撑。

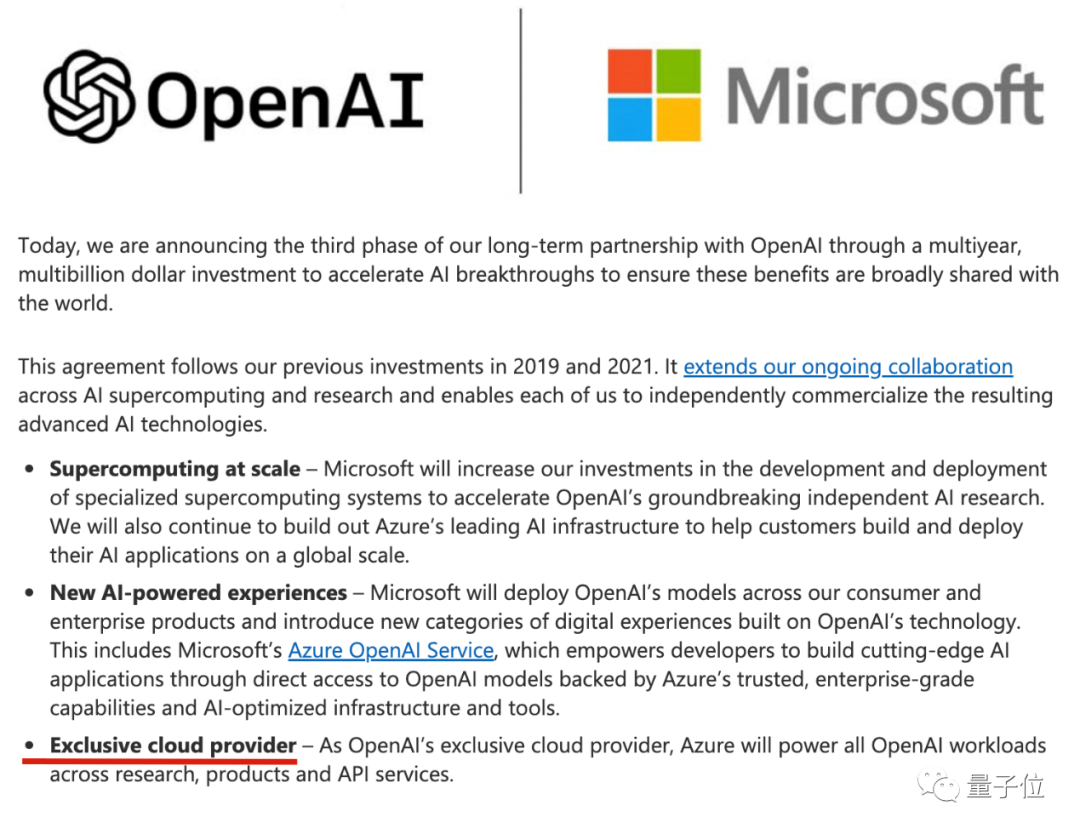

ChatGPT最直接的计算能力提供商是微软Azure Cloud,自2019年首次向OpenAI投资10亿美元以来,它一直是OpenAI的独家云提供商。

最新增加100亿美元投资时,双方在声明中再次强调了这一点。

独家供应是指OpenAI的开发基础设施全部建立在Azure云上,使用Azure云提供的工具链。

这也意味着,即将到来的AI创业大军要想基于ChatGPT,只能选择Azure云。

相应的,Google AI背后有自己的Google云,云计算行业第一的亚马逊也紧急找到HuggingFace合作部署开源模型Bloom。

……

云计算不是计算能力的来源。就在ChatGPT火热的时候,在计算能力的供给端出现了一批业绩突出的公司。

你可能马上会想到一些玩家,但也有一些参与者可能是意料之外的,因为之前其他业务太出名了。

其中,有一位来自中国的选手。

新摩尔定律,离不开算力

年,当以图像识别和推荐算法为代表的最后一波AI应用落地并推动数字经济发展时,计算能力从一个技术术语上升为一个经济术语,被业界和学术界反复强调。

当这一波生成性AI引爆全球热情时,计算能力再次升级为与普通人的工作生活相关,被大众感知。

ChatGPT多少钱?

半导体行业的信息机构SemiAnalysis做过一个估算:以GPU衡量,大约需要3617台英伟达HGX A100服务器,即28936台A100服务器;资金方面,每个问题的成本是0.36美分,一天要花69万美元。

结论是,如果让ChatGPT承担谷歌搜索的所有访问量,总共需要410万个NVIDIA A 100 GPUs。

所以自然,NVIDIA是火热的ChatGPT中最有名的奸商。目前,英伟达在AI芯片市场的份额约为75%-80%。ChatGPT的每次热搜都是老黄账号金币的声音。在这波热潮的加持下,到最新财报发布时,英伟达股价在2023年上涨了45%。

CEO黄仁勋也在电话会议上发表了最新声明:

“生成式人工智能让全球企业在开发和部署人工智能方面有了战略紧迫感。”

而这仅仅是开始。据花旗银行预测,未来12个月,英伟达的GPU销售额将达到30亿至110亿美元。

在英伟达之外,从GPU上游追溯的ChatGPT红利的赢家是位于芯片制造层的TSMC。

最近有消息称,英伟达、AMD和苹果公司近期已经对TSMC下了紧急订单,希望抢占未来产能。

此前,TSMC的收入支柱多年来一直是智能手机业务。但2022年,在智能手机销售惨淡和人工智能爆发的双重影响下,高性能计算业务连续三个季度超过——,这或许也是时代转折的第一个征兆。

更重要的是,TSMC实际上已经清楚地表明了这一变化。在近期的外部声音中,TSMC给出了对未来一年的乐观预期,表述也十分耐人寻味:虽然全球半导体行业面临衰退,但全年业绩仍有望小幅增长。

当然,如果更简单粗暴一点,其实NVIDIA崛起的时候,TSMC的表现也不会差。毕竟产业链的作用和供求关系都在。

那么按照这种供求关系,ChatGPT带来的计算红利是否也会到达云计算和云服务厂商?

是的,不是全部。

在ChatGPT的流行中,很多分析都指向云计算,但也有一些分析迅速聚焦到云计算服务的中间链路——GPU到中间链路—— server。

芯片要想真正发挥作用,就不能绕过服务器:芯片如何高速互联,如何控制整个机柜的能耗和散热,如何使系统设计适应不同的工作负载,这些都影响着最终的性能和效率。

Gartner预测,到2025年,全球服务器市场规模将达到1350亿美元,其中AI服务器和AI云服务将呈爆发式增长。

正是在这个环节,在AI服务器方向,隐藏着文章开头提到的来自中国的计算参与者。

联想集团,联想。

也许之前,你对联想集团的了解更多的是关于PC,但PC的本质也是个人计算能力。

从PC到高性能计算,再到更广泛的计算基础设施,联想走过了这样一条路。

这一点有最直观的财务数据为证。根据联想集团发布的第三季度财报(2022年10-12月),其ISG(infra structure Solutions Group)基础设施解决方案业务收入增长48%,营业利润飙升156%。

与DigiTimes相比,全球服务器出货量同比下降7.1%,环比下降4.3%。

联想ISG提供以计算能力为核心的基础设施输出和解决方案,服务器是最重要的业务之一。

并且更直接细分到服务器业务,本季度营收同比增长35%,已经成为全球第三大服务器提供商。GhatGPT的计算奖金功不可没。

但ChatGPT的突然爆发,其实只是把联想作为计算能力赢家的隐性角色推到了台前。

联想靠什么成为算力“隐形”冠军?

联想集团董事长兼CEO杨表示,ChatGPT背后需要的通用计算基础设施正是联想布局多年的强项。

联想早就预见到了计算设备的需求,提出了“端-边-云-网-智”的全新IT架构。

去年,联想进一步提出了通用计算能力。即随着数据的爆炸式增长,我们进入了一个全新的数字化、智能化时代,对计算的需求如雨后春笋。“单兵作战”的设备和本地化的数据中心已经远远不能满足随时随地的计算需求,需要“端-边-云-网-智”的新IT架构为用户提供无处不在的计算能力。

由此可见,联想要做的并不是生产计算能力的“水源”,而是“送水人”——将芯片集成为一个可以高效释放计算能力的服务器,不容易被外界感知。

在这个角色和定位上,联想集团非常“强势”。——的强大核心是两个方面。

一个是服务器产品的性能;二是数量规模。

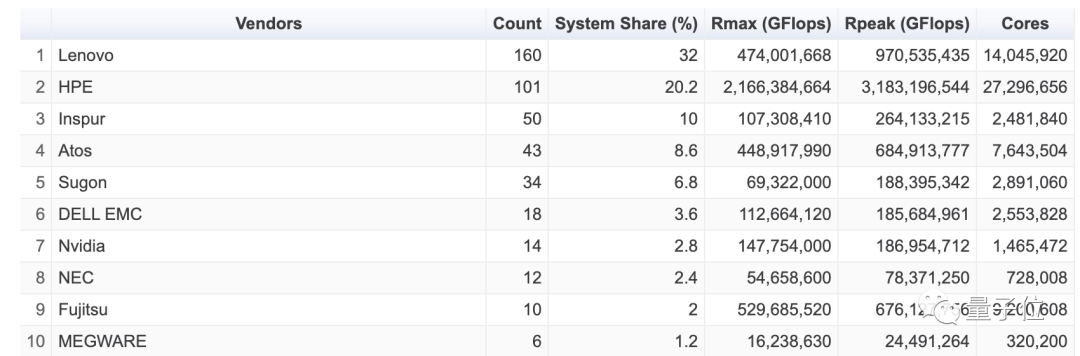

在这个领域,全球高性能计算排行榜TOP500是观察服务器计算能力的最佳参考,而如果打开最新一期的Top 500(2022年11月),就能感受到上面提到的联想集团的实力。

市场份额占比32%,以160台的供应量位居全球第一,甚至领先第二名惠普集团近12个百分点。

而且联想集团的计算电源在客户构成上也具有普遍性和多样性。

联想集团执行副总裁柯克斯考根(Kirk Skaugen)在回答《日本经济新闻》的提问时,曾以凡尔赛风格透露,全球前10大公有云提供商中,有8家是联想集团的客户。

换句话说,联想服务器得到了全球客户的认可,这对于国内服务器厂商来说并不容易。

在这些客户中,外界猜测包括云领域排名第二的微软Azure Cloud ——ChatGPT背后的加速引擎,以及“金主爸爸”。

在微软斥巨资支持OpenAI的时候,有评论认为精明的微软CEO纳德拉会用真金白银进行投资支持,核心提供等价的云服务,不仅收购了OpenAI的股权,还实现了顶级AI研究机构的战略布局,为自己的Azure云带来了客户和增长。简直是一举两得,这笔生意不能亏本。

只是没想到,疯狂的OpenAI真的是以一个大模型扬名立万。它真的以ChatGPT的一次偶然创新点燃了全球科技互联网,让所有玩家陷入了一个大模型和一个生成性AI的沸腾。

微软不仅率先受益,还把老对手谷歌逼到了墙角,动摇了谷歌搜索的摇钱树。纳德拉估计最近的梦很甜。

与微软有着密切合作并在2022年获得微软设备合作伙伴奖的联想集团,已经直接在财务表现上显示出了甜头。

此外,也正是这种关系,可以理解为什么微软CEO纳德拉在2021年的联想创新科技大会上亮相,但当年的宣布过于“行业俚语”,需要结合今天的ChatGPT红利才能真正理解。当时的公告是这样写的:未来双方将在PC、云计算、边缘计算、服务等方面开展更加深入的合作。

但即使联想集团成为ChatGPT的计算能力提供商,是否意味着这种前景是可持续的?毕竟微软和ChatGPT的案例有其特殊性,幕后的联想集团有侥幸的因素尝到了甜头。

但从ChatGPT建立的大模型的发展方向来看,趋势还会继续,计算能力的供给侧也会发生方向性的变化。

根据最近《财经十一人》基于众多基础设施人的意见得出的结论,AI计算能力将对云计算的金融模式产生重大影响,其背后是摩尔定律的指数增长逻辑:

第一,AI算力的消耗和增长速度会远大于一般算力。根据2022年信通院数据,2021年,我国通用计算能力规模为95EFlops,增长率为24%,占比47%。智能计算能力规模为104EFlops,增长率为85%,占比超过50%。这意味着智能计算能力将成为云计算的新一轮增长点。

第二,智能算力的价格高于通用算力。通用计算能力的价格在不断降低。由于AI计算能力相对稀缺,目前价格被推高。理论上,实现大规模运算的AI算力比一般算力的毛利率高10%以上。

第三,AI算力模型在垂直行业的运用,可以催生新的应用模式。比如在金融、自动驾驶、医疗研发、智能制造等场景下,企业通常需要购买本企业的AI大模型开源平台,调整适合自身业务的小模型。这种PaaS AI服务可以带来60%以上的毛利。这是目前最能深化AI算力/AI模型使用的方式。

这种人工智能计算能力方向的变化,具体到中国市场,还可以推导出更具体的影响:

目前不可否认的是,中国云厂商的AI算力和big model与微软的差距很大。原因是计算能力规模、数据规模、模型精度有差距。以计算能力规模为例,支持ChatGPT的智能计算集群至少需要上万块NVIDIA GPU A100显卡。一次完整的模特培训花费超过1200万美元。

ChatGPT背后的智能计算集群,仅GPU显卡采购成本就超过10亿元。目前国内能支撑类似基础设施的企业不超过三家。中国云厂商的数据中心通常只配备几千块GPU显卡。原因是购买一个英伟达顶级GPU的成本高达8万元。一台服务器通常需要4 -8个GPU,一台GPU服务器的成本通常超过40万元。国内平均价格

所以,明确了这两个结论,我们大概就能知道,为什么联想集团作为ChatGPT红利背后的隐性赢家,在未来的计算力方向上会持续可持续。

如果计算能力满足新摩尔定律,能耗的问题就不容忽视。国家发改委高技术司主要负责人21年表示,我国数据中心年用电量约占全社会用电量的2%。

说的更直观一点,就是说“年用电量超过2.5三峡大坝发电量”,摩尔定律是指数增长,三峡大坝发电量不可能指数增长。

联想集团为此研发了领先的波塞冬温水冷却技术,利用50的温水通过流动循环带走热量,省去了冷水机组和热交换器,还可以利用余热为建筑供暖,每年节省电费,减排42%以上。

在最新的全球HPC Green500榜单上,联想集团交付的Henri系统每瓦功耗可执行65.091亿次浮点运算,不仅满足国内外要求,还成为全球最节能的高性能计算系统。

其实联想已经不是你刻板印象中只有电脑的公司了。整体来看,在计算基础设施业务迎来爆发的同时,联想集团整体逐渐完成转型:个人电脑以外的业务占总营收的比重已经超过40%。

ChatGPT,big model,甚至AI,在技术创新周期中率先涌动的计算力红利,正在刷新着联想集团,或者更准确地说,将计算力供给端的幕后隐形冠军推到了台前。

结束—

(报道)

- 上一篇 : 从“种草营销”的角度重读小红书

- 下一篇 : 躁动的春天 200万人“抢”周杰伦