谷歌的野心:通用语音识别大型模型已经支持了100种语言

发布时间:2023-03-10 09:22:51作者:顺晟科技点击:

去年11月,谷歌为构建支持世界上使用最广泛的1000种语言的机器学习(ML)模型,开发了& amp# 039;1000种语言方案& amp# 039;通过发表,提高了对全世界数十亿人的包容性。但是,其中一些语言不足2000万人,因此核心挑战是如何支持使用相对较少或可用数据有限的语言。

目前,谷歌公开了关于通用语音模型(USM)的详细信息,这是支持1000种语言的第一步。USM包括一系列SOTA语音模型,通过20亿参数、1200万小时的语音和280亿个文本句子培训,涵盖300多种语言。USM不仅可以对英语和普通话等广泛使用的语言进行自动语音识别(ASR),还可以对阿姆哈拉语、宿务语、阿萨姆语、阿塞拜疆语等使用人数较少的语言进行自动语音识别。

谷歌使用未标记的大规模多语言数据集,对模型的编码器进行了事先培训,并将其微调为较小的标记数据集,证明了模型可以识别少数语言。另外,Google的模型培训课程可以有效地适应新的语言和数据。

USM支持的语言示例。

当前的挑战

谷歌是& amp# 039;1000种语言方案& amp# 039;为了实现,需要应对ASR的两大挑战。

首先,传统的监督学习方法缺乏可扩展性。将语音技术扩展到多种语言的基本任务之一是获得足够的数据来训练高质量的模型。传统方法要求手动显示音频数据,这既费时又费钱。可以从现有数据中收集可用数据,但使用人数少的语言很难找到。

相比之下,自我监督学习可以利用大量语言组成的纯音频数据,这将成为将自我监督学习扩展到数百种语言的好方法。

另一个挑战是,要扩大语言覆盖范围,提高模型质量,同时以高效的方式改进模型。这需要学习算法的灵活性、效率和泛火星性。更具体地说,算法必须能够使用多种来源的大量数据,在没有完全再培训的情况下激活模型更新,并扩展到新的语言和用例。

解决方法:有微调的自我监督学习

USM使用标准编码器-解码器体系结构。其中解码器可以是CTC、RNN-T或LAS。对于编码器,USM使用Conformer或卷积增强转换器。Conformer的核心组件是Conformer块,它由注意模块、前馈模块和卷积模块组成。以语音信号的log-mel声频谱作为输入,进行卷积缩减采样,然后应用一系列Conformer块和投影层,得到最终嵌入。

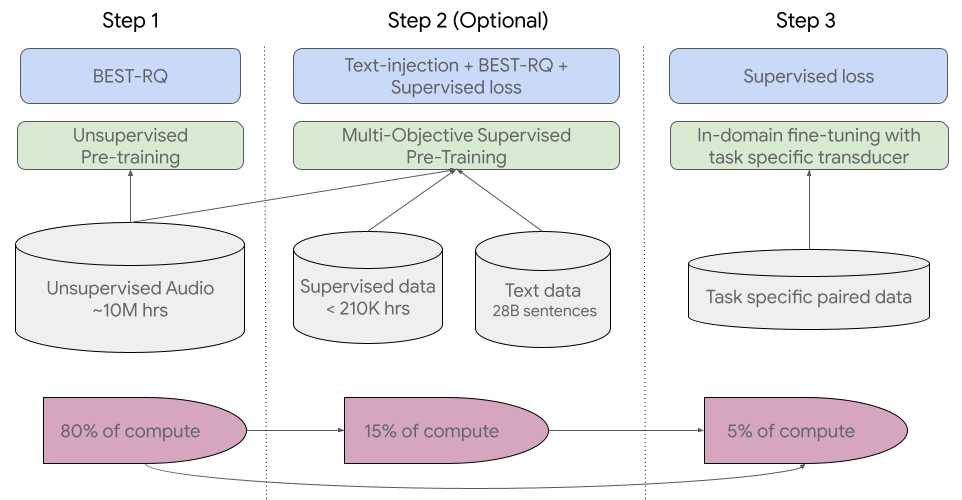

USM的培训流程如下图所示。

第一步从对涵盖数百种语言的语音音频进行自我监督学习开始。

第二步是可选的,Google使用文本数据进行进一步的词典培训,以提高模型的质量和语言覆盖范围。是否执行此步骤取决于文本数据是否可用。

Pipeline培训的最后一步是使用少量监督数据微调下游操作(如ASR或自动语音翻译)。

USM的整个培训课程。

在第一阶段,Google使用了BEST-RQ,因为它在多语言工作中展示了SOTA结果,在使用大量未监督的音频数据时被证明是有效的。

在第二阶段,Google使用了多目标监督预先训练,以整合附加文本数据的知识。USM模型引入了以文本为输入的附加编码器模块,引入了将语音编码器和文本编码器的输出相结合的附加层,然后集成了关于未标记语音、标记语音和文本数据的培训模型。

通过在培训前期间获得的知识,最后阶段USM模型在下游工作中只需要少量的监督数据,就可以获得良好的模型性能。

显示主要结果

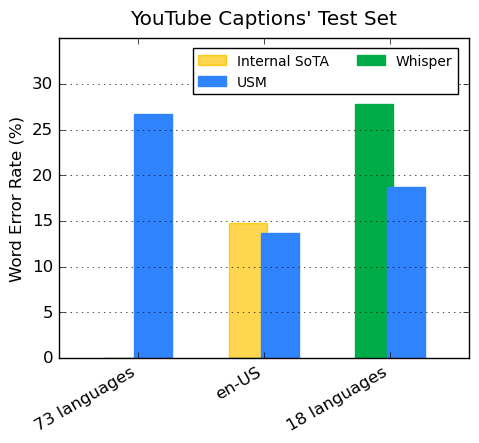

YouTube Captions测试集中多种语言的性能

Google的编码器通过事前训练整合了300多种语言,并对YouTube Caption多语言语音数据进行了微调,证明了事前训练编码器的有效性。监视式YouTube数据包括73种语言,每种语言的数据平均不超过3000小时。尽管受到监督数据的限制,USM在73种语言中平均达到了不到30%的单词错误率(WER,越低越好),这是以前没有实现的里程碑。就En-US而言,与目前谷歌内部SOTA模型相比,USM的WER相对减少了6%。

谷歌还与OpenAI最近发布的大型机型Whisper (large-v2)进行了比较。Whisper (Large-V2)使用超过400k小时的标记数据进行了训练。为了便于比较,谷歌只能使用Whisper成功解码,WER仅使用不到40%的18种语言。结果如下图所示,USM的平均WER比Whisper低32.7%。

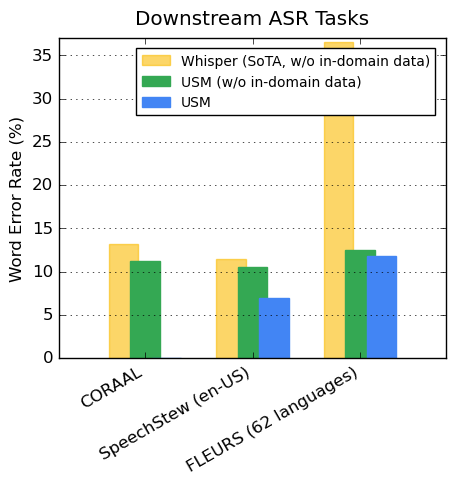

下游ASR操作的泛化性能

对于公开可用的数据集,USM在CORAAL(非裔美国土著语言)、SpeechStew(en-US)和FLEURS(102种语言)数据集上显示的WER低于Whisper。USM没有接受或接受域内数据培训,实现了较低的WER。具体结果如下图所示。

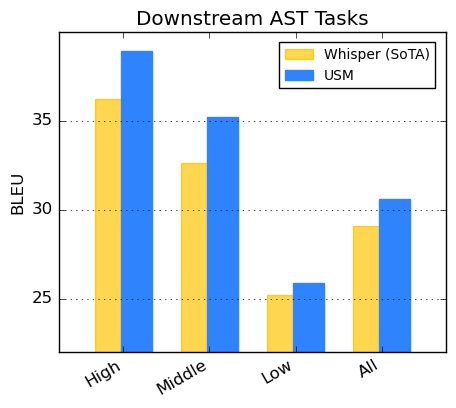

自动语音翻译(AST)性能

对于语音翻译,谷歌微调CoVoST数据集。谷歌的模型(包括pipeline的第二阶段文本)以有限的监督数据实现了SOTA性能。另外,为了评估模型性能的广度,Google根据资源利用率将CoVoST数据集的语言分为高(high)、中(medium)、低(low),并计算相应的BLEU分数(越高越好)。

如下图所示,USM在所有语言细分上都超过Whisper。

以后将支持1000种语言

USM的发展是& amp# 039;Google组织全球信息,让所有人都能访问& amp# 039;这是实现使命的核心努力。谷歌认为,USM的基础设施模型基础设施和教育pipeline为未来将语音建模扩展到1000种语言奠定了基础。

详情请参阅相关论文https://arxiv . org/ABS/2303.01037 v2

原文链接:https://ai . Google blog . com/2023/03/universal-speech-model-USM-state-of-art;

(申报)

- 上一篇 : 主播等岗位爆炸的背后 平台和机构如何帮助新青年群体找到工作?

- 下一篇 : 快手字节房地产 能吃多少红利?